就在刚刚,马斯克的大模型公司xAI宣布,正式开源3140亿参数的混合专家模型Grok-1,并向公众开放下载。该模型遵循 Apache 2.0协议开放模型权重和架构,号称是“迄今为止全球参数量最大的开源大语言模型”。

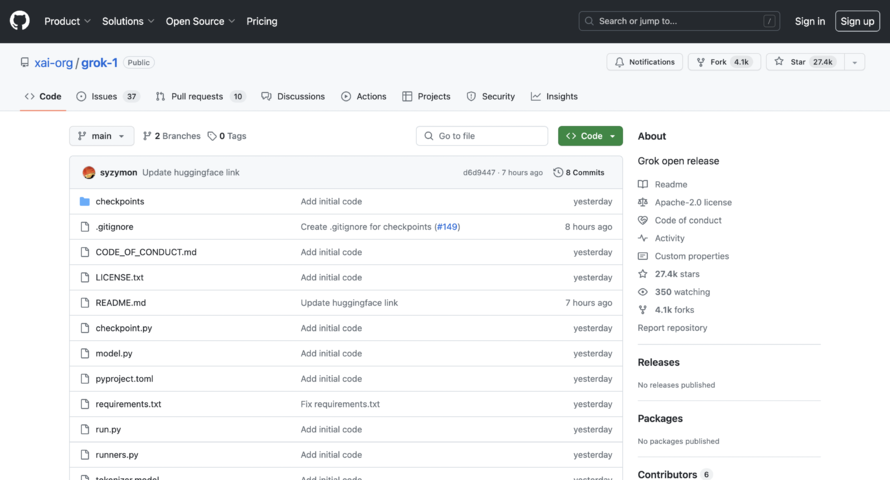

Apache 2.0 许可证允许用户自由地使用、修改和分发软件,无论是个人还是商业用途。项目发布短短几个小时,已经揽获27.4k星标,热度还在持续增加。

开源地址:https://github.com/xai-org/grok-1

Grok的开源意味着什么?

xAI表示,Grok的设计灵感来源于科幻小说《银河系漫游指南》(the Hitchhiker’s Guide to the Galaxy),旨在为用户提供尖刻而富有洞见的回答。它能够回答几乎所有问题,助力人类不分背景或政治立场地追求理解和知识。

回到模型本身,Grok最初的版本Grok-0拥有330亿参数,紧接着xAI推出了经过数次改进的Grok-1,为X上的Grok聊天机器人提供支持。Grok-1始终由xAI自行训练,其预训练阶段于2023年10月完成。

此次发布的是Grok-1预训练阶段结束时的原始基础模型检查点,这意味着该模型没有针对任何特定的应用程序(例如对话)进行微调。相对的,在X(原Twitter)上可用的Grok大模型是微调过的版本,其行为和原始权重版本并不相同。

结构上,Grok-1的MOE架构旨在提高大模型的训练和推理效率。MOE就像把各个领域的“专家”集合到了一起,遇到任务派发给不同领域的专家,最后汇总结论,决定每个专家做什么,被称为“门控网络”的机制。

xAI还公布了Grok-1的更多细节:

Grok-1是一个未针对特定任务进行微调的基础模型,它基于大量文本数据训练而成;

作为一款基于混合专家技术构建的大语言模型,Grok-1拥有3140亿参数,在处理每个Token时有25%的权重处于活跃状态;

Grok-1是xAI团队使用JAX和Rust编程语言自定义训练栈从零开始训练的成果,训练完成于2023年10月;

一般而言,参数数量的增加意味着模型更为先进、复杂且性能卓越。在这方面,Grok-1展现出了显著的优势,它拥有惊人的3140亿个参数,这一数字远超其开源竞争对手,如Meta的Llama 2和Mistral 8x7B。

Grok遵循Apache License 2.0 的开放源代码原则,不仅允许商业使用、修改和分发,而且不限制商标的注册。然而,用户在使用时需复制原始许可证和版权声明,并注明所做的修改,同时不承担任何责任或保证。

Grok的架构堪称创新之作,它于2023年10月在JAX和Rust上的定制训练堆栈中孕育而生,并采用了先进的神经网络设计。该模型在处理给定标记时,仅需运用25%的权重,这一策略极大地提升了其效率和实用性。

与OpenAI之间的一次正面交锋

开放Grok聊天机器人代码的举动,不仅仅是技术上的举措,也是马斯克与ChatGPT的创造者OpenAI之间的一次正面交锋。马斯克曾是OpenAI的创始人,但后来离开并提起诉讼,指控其违反了开放和透明的承诺。

马斯克坚信,如此重要的技术不应该只被谷歌、微软等少数科技巨头所控制,而应该让更多的人参与进来。微软是OpenAI的亲密合作伙伴,OpenAI已表示将寻求采取行动驳回马斯克的诉讼。

马斯克认为,“对比ChatGPT等其他AI聊天机器人,Grok最大的特点是存在幽默感。”Grok为人们提供了一个更加自由、开放的交流空间,让人们能够更加真实地表达自己的思想和情感。

马斯克此次选择将Grok的代码开源,即公开给所有人查看和使用,再次体现了他对开源理念的坚定支持。去年,他就曾对X的推荐算法进行同样的开源操作,尽管之后并未进行更新。

未来,xAI还计划与其他科研机构进行更紧密的合作,并推动相关标准化工作。同时,他们也鼓励各界对Grok-1进行改进优化,并期待看到更多基于这一模型实现的前沿应用问世。