大模型技术的发展与落地应用正走入新阶段,挑战和机遇并存。

日前举办的「2024春季火山引擎FORCE原动力大会」正式发布了字节跳动豆包大模型家族、火山方舟2.0、AI应用及AI云基础设施等最新产品。豆包大模型价格更是让所有人眼前一亮,主打一个良心价格,豆包通用模型pro-32k的推理输入价格只有0.0008元/千tokens,比行业便宜99.3%。

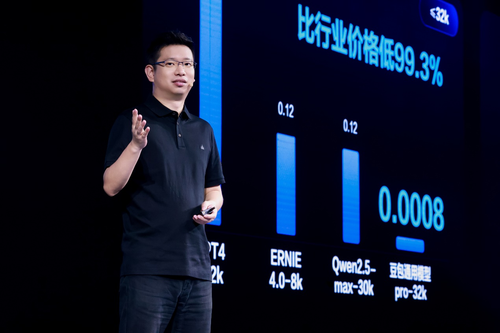

火山引擎总裁 谭待

“大模型的超低定价,来源于我们在技术上有信心优化成本。”火山引擎总裁谭待表示。大模型正深入千行百业,火山引擎给企业应用大模型提供了一个更优、更好的选择。

当前大模型落地有哪些挑战和机遇?企业如何快速训练出适合自己的大模型?如何减少试错成本?ITPUB就相关问题采访了火山引擎相关专家,分享了火山引擎的思考和实践。

大模型落地机遇和挑战

大模型出来之后,很多企业和个人都在积极尝试。

火山引擎大模型算法服务负责人王科指出:“2023年整个大模型领域更多是在做原型探索,比如手机、汽车、教育、游戏、社交、企服等行业过去一年进行了大量尝试。另外,从2023年下半年开始,我们也看到一些AI Native的创业公司开始成立。2024年我们相信是从探索到落地的一年,可以期待大模型在更多应用场景落地,并产生更大的商业价值。”

整体上大模型的发展还处在早期探索阶段,本身大模型技术在快速变化,基于快速变化的大模型技术去构建上层产品,必然存在一些挑战和不确定性。

“企业要做好大模型落地,面临模型效果、推理成本、落地难度的三大关键挑战:既要有好的基础大模型做支撑,解决复杂难题,也要有低成本的推理服务让大模型被广泛应用,还要更多工具、平台和应用帮助企业做好场景落地。”谭待表示。

较高的试错成本往往是阻碍新技术应用落地的一个关键因素,王科指出,企业只有实际用了大模型之后,才能知道模型在自己的场景会有怎样的效果,但是企业创新肯定会考虑ROI(投资回报率),这就需要综合考虑模型效果与成本,高成本会抬高企业使用大模型的门槛。

比如在成本方面,如果是业务体量较大的客户,以手机厂商为例,即便在一个场景稍微用一点,由于存量业务太大也会导致很高的成本。但是对于新业务或者创业公司而言,新业务本身还在一个创新期、探索期,在大模型方面也难以承担比较高的成本。

此外,由于大模型技术很新,技术变化快,市场上大模型也较多,选择一个好的模型,并且在企业实际场景中打造出好的应用效果 ,也是企业面临的问题。

据火山引擎大模型工程负责人雷景言观察,在技术工程方面企业应用大模型也存在一些挑战:

一是,大模型在深入行业落地时,很多用户会通过精调来打造更适合企业的大模型。精调本身并不复杂,困难在于如何高效精调,平衡好成本和训练速度。模型精调之后的推理部署,特别是精调迭代的量比较多,需要在不同的精调模型版本之间做灰度发布和 AB测试对比,为应对推理流量峰值变化,底层要有足够的弹性才能控制好成本。

二是,安全方面的顾虑,一方面企业可能会担心样本数据安全泄露或者安全攻击的风险。另外一方面,生成式模型产生的内容可能会给业务带来风险,比如出现一些违规内容,这需要及时的干预能力,现在火山引擎很多用户希望在 30分钟之内,将安全规则全部准确发下去。

三是,为了算法的效果,大模型本身的推理计算量,以及模型与周边知识库和其他周边系统的大量交互,会带来延迟挑战,这对系统的软硬结合计算效率优化提出了很高的要求。

雷景言认为,一些场景已经被OpenAI教育出来,大家已经逐步摸索出如何去用大模型。目前,从技术工程视角来看,国内主流大模型的调度、推理优化能力与GPT-4接近,算法效果发展更快一些,在一些局部场景甚至可以超过GPT-4。

火山引擎对大模型未来的发展有信心也非常笃定,大模型是一个基础设施,会与每家企业和每个人都产生关联,长期来看是对社会影响很大的技术。新一代的模型会解锁新的市场空间,而且随着模型能力不断演进,所解锁的市场空间会越来越大。

对于大模型这样的早期技术,实践出真知。需要企业做更多的尝试,才能探索出切实可行的落地路径,推动大模型深入行业创造价值。

为了解决上述大模型落地的挑战,让大家可以没有负担地尝试大模型,火山引擎把给客户的成本做得足够低,给企业一个更优选择。

给企业一个更优选择

什么是好的大模型?可能一千个人有一千种不同的答案。

谭待认为,只有大的使用量,才能打磨出好模型。他还强调,降低成本是推动大模型快进到“价值创造阶段”的一个关键因素。这体现了火山引擎对好的大模型很朴素的观点,不看榜单、参数,更关注场景应用和效果。而且,人人用得起,才是好模型。

会上字节跳动自主研发的豆包大模型将通过火山引擎正式对外提供服务,豆包大模型家族包括豆包通用模型pro、豆包通用模型lite、豆包·角色扮演模型、豆包·语音合成模型、豆包·声音复刻模型、豆包·语音识别模型、豆包·文生图模型、豆包·Function call模型、豆包·向量化模型,企业可根据自身业务场景需求灵活选择、快速落地。

据悉,豆包大模型是字节跳动专业算法团队打造,通过字节跳动内部50+业务场景实践验证,千亿级日tokens的持续打磨,让模型效果有保证、业务适配更精准。且该模型首批通过大模型服务安全备案,满足合规性需求,企业放心使用。目前,豆包大模型日均处理1,200亿tokens文本、生成3,000万张图片。

火山引擎给出了一个超低的模型价格,以豆包通用模型pro-32k版为例,模型推理输入价格仅为0.0008元/千tokens。而市面上同规格模型的定价一般为0.12元/千tokens,是豆包模型价格的150倍。大模型价格,进入“厘时代”。在模型推理定价大幅低于行业价格的基础上,豆包通用模型的 TPM(每分钟Tokens)、RPM(每分钟请求数)均达到国内最高标准。每分钟处理token的限额是业内同级别模型的四到八倍,能满足绝大多数企业的业务需求。

谭待表示,火山引擎有信心通过技术优化降低成本。例如通过对模型结构的优化调整、在工程上从以前的单机推理演进到现在的分布式推理、把不同负载的推理混合调度,这些技术能够把各种各样底层算力用得更好,同时实现大幅地降低成本,让每一家企业都能用得起大模型。

实际上,客户在应用大模型时主要有两种路径,一是基于开源模型训练专有模型,这需要有很强的技术储备,一些头部企业可能会采用此种方式。二是调用MaaS(模型即服务)的API服务,大部分企业会选择MaaS服务。

火山引擎提供应用服务、MaaS、云计算服务全栈的AI服务,以场景驱动,加速大模型探索和落地应用,让企业更容易享受到AI技术发展红利。

在模型生产端,火山引擎通过优秀的算力系统和机器学习平台打造出安全可靠、高效的“模型生产工场”。平台拥有高效的训练和推理的编排、调度能力,对算子库、通信库等通用系统优化,以一种很低的侵入和接近透明的方式提供给客户。国内主流的大模型创业公司基本都在其机器学习平台里完成训练,资源编排调度能力和故障卡自愈能力受到好评。

升级后的机器学习平台,通过GPU碎片资源自动优化,进一步提升资源利用率。此外,用户调试好模型环境,可以构建Docker镜像用来稳定训练,起一个大规模的训练环境只需要2秒钟,增加了平台的易用性。

在模型应用端,去年火山引擎发布了一站式大模型服务平台火山方舟,通过模型即服务的理念,精选优质大模型,帮助企业在高效、安全的环境里应用各类模型。今年,火山引擎对方舟平台进行了全面升级,升级后的火山方舟2.0将以更强性能、更优插件、更好服务、以及全周期安全可信方案,助力大模型应用落地。

雷景言介绍,火山方舟更强调提供大模型全生命周期管理,提供对开源、闭源大模型的运维纳管,尤其是闭源模型的运维管理集成了火山引擎的优秀实践,帮助客户在闭源模型“黑盒”情况下,更好地去运维服务,提供更稳定的支撑能力,找到算法效果和落地成本的最 优解。

云底座方面,火山引擎超大规模算力集群,支持万卡集群组网。支持公有云、混合云以及异构算力,为AI创新提供规模化、高稳定性的云基础设施。

可以看到,火山引擎提供在广泛业务场景(字节跳动内部、火山引擎服务的外部客户)打磨出来的好模型,同时也将训练大模型、应用大模型的优秀工程实践通过火山方舟、机器学习平台等平台对外提供服务,让企业更低成本、更高效率、更安全稳定地应用大模型。

小结:让大模型飞入寻常企业

越来越多的企业正在应用大模型创造价值,以证券行业客服场景为例,传统证券客服体系存在产品形态孤立、意图识别泛化性不足、缺乏多轮会话理解能力等问题,导致客户使用体验不佳。华泰证券基于火山引擎方舟平台构建了新一代的财富管理助手,解决了传统技术无法对意图进行精准识别、无法与客户之间进行多轮交互的问题,提升了用户体验。

更低的价格,更低的试错成本让更多企业敢于尝试大模型,通过不断尝试与了解,大家的预期也会更加理性,大模型才能更持续、健康地发展。在AI时代,火山引擎既授人以鱼也授人以渔,其全栈大模型服务助力大模型飞入寻常企业,给企业一个新的选择。