SLM(小语言模型)专为高效性设计。在资源有限、需要实时响应或注重隐私的环境中,它们表现优异,而LLM(大语言模型)则显得大材小用。

最适合聚焦特定任务,尤其是当领域专一性、控制力和可解释性比通用知识或创造力更重要时。

SLM并非LLM的替代品,但当精确性、速度和成本效益是优先级时,它们是更优选择。

技术帮助我们以更少资源达成更多目标。它始终是推动者而非驱动者,从蒸汽机时代到互联网泡沫,技术的核心价值在于解决问题的能力。人工智能(AI)和近期的生成式AI也不例外!如果传统机器学习模型足以胜任某项任务,就无需使用输出难以解释的深度学习模型。大型语言模型(LLMs)也是如此,更大并不意味着更好。本文将帮助你判断何时应为特定问题选择小语言模型(SLM)而非大语言模型(LLM)。

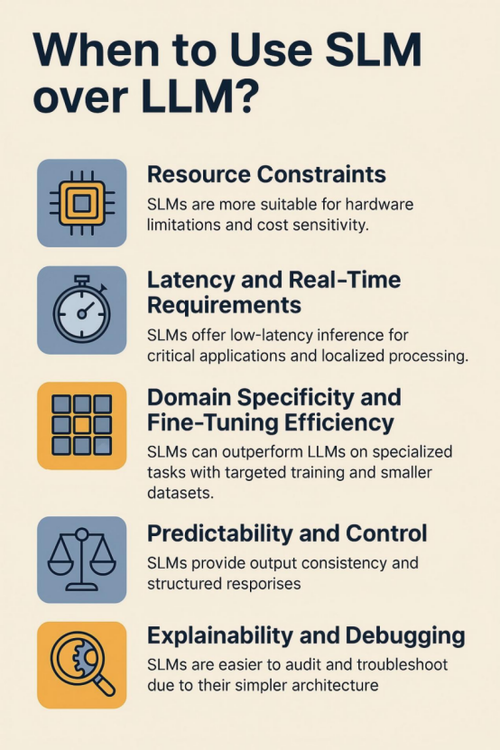

推动选择SLM的核心因素

小语言模型是适用于多种自然语言处理(NLP)任务的灵活工具。选择LLM还是SLM时,关键问题不仅是“模型能做什么”,更是“用例需要什么”。SLM并不追求与LLM的规模或通用性竞争,其真正优势在于高效、专注和场景适配。

以下是促使选择SLM的核心因素:

资源限制

硬件限制

许多场景中,将模型部署在移动设备、微控制器或边缘系统不仅是锦上添花,更是唯一可行的选择。在此类环境中,每兆字节和每毫秒都至关重要。SLM足够轻量化以适配这些限制,同时仍能提供智能化的价值输出。

我们讨论的模型可在树莓派或智能手机上离线运行,无需依赖互联网或高性能GPU。这对于离线应用(如智能家电、可穿戴设备或偏远地区的嵌入式系统)至关重要。

示例: 在偏远村庄的低成本物联网设备上实现实时翻译。

成本敏感性:

有时问题不在硬件,而在规模。若需每日处理数百万次低复杂度请求(例如自动标记支持工单或生成基础摘要),LLM在财务和运维层面都显得多余。

SLM提供了替代方案。你可以对其进行一次性微调,在本地基础设施或普通GPU上运行,并省去LLM API的持续成本。这对内部工具、面向客户的实用程序和高频重复性NLP任务而言是明智之选。

示例: 在不超支的情况下自动化处理每日10万条支持请求。

延迟与实时性需求

关键应用:

在某些用例中,速度不是奢侈品,而是硬性要求。例如无人机接收语音指令、增强现实系统响应动作或车载语音助手。这些场景的决策需实时完成,模型没有时间进行复杂计算或云端往返。

由于体积小、复杂度低,SLM能提供本地化低延迟推理,成为时间敏感型任务的理想选择。

示例: 即时解析语音指令以降落无人机,而非等待数秒。

本地化处理:

延迟不仅是速度问题,更是独立性问题。依赖互联网接入会增加应用的脆弱性:网络中断、带宽限制和隐私风险。相比之下,SLM可完全部署于设备端,摆脱对云端的依赖。

这在医疗或金融科技等隐私敏感领域尤为重要。保持数据在设备端不仅是性能选择,更是合规要求。

示例: 偏远地区的智能健康亭可在离线状态下处理患者查询,无需上传任何数据至云端。

领域专一性与微调效率

定向专业知识:

关于AI的最大误解之一是“模型越大,答案越好”。但在实践中,若任务高度专业化(如医疗报告标记、合同条款分类或特定代码生成),你不需要全网知识,只需对特定领域的聚焦理解。

SLM可通过领域专有数据快速高效微调,且常因专注训练而在细分任务中胜过LLM。

示例: 专门针对法律合同训练的模型,其条款标记效果优于通用LLM。

降低数据需求:

训练或微调LLM通常需要海量多样化数据集和大量GPU时间。而SLM只需少量精选数据即可完成任务适配,这意味着更快的实验周期、更低的开发成本和更少的数据治理负担。

这为初创公司、研究人员和内部团队(尤其当标注数据或算力有限时)提供了可能性。

示例: 用5000条标注客户查询微调SLM,即可为产品构建智能客服,无需实验室级预算。

可预测性与控制力

输出一致性:

在实际部署中,一致性往往比创造性更有价值。例如生成发票摘要、SQL查询或合规检查清单时,你需要精确输出,而非每次创意重述。

由于体积小、训练范围窄,SLM行为更趋确定性。经良好微调后,它们能生成高度可复现的输出,适合依赖结构化模板的用例。这不仅是技术优势,更是企业级工作流的业务需求。

相比之下,LLM可能在不同会话中略微调整措辞,或生成冗长、偏离格式的响应。虽然这种可变性在头脑风暴或自然对话中有益,但在结构化场景中会引入风险或摩擦。

示例: 生成结构化医疗摘要或自动化税务报告时,固定格式的每个字段都需要SLM提供的可预测性。

可解释性与调试

为所有读者澄清以下术语:

可解释性指理解模型为何做出特定预测或决策的能力。例如,哪些特征或训练样本导致了某次分类或输出?

调试指诊断、追踪和修复模型中不良行为(如错误分类或生成响应中的逻辑错误)的能力。

在真实AI工作流中,这些能力不可或缺!你需要信任系统、为其输出提供依据,并快速排查错误。

SLM凭借较小的架构和领域专有训练更易于审查。其预测常可追溯至具体训练样本或提示结构。由于训练周期短,迭代调试和改进对小团队也更易实现。

示例: 在法律科技应用中,若SLM标记某合同条款不合规,领域专家可快速追溯该决策至模型对类似条款的训练,验证逻辑并按需调整。

相比之下,解释庞大LLM的行为常如逆向解析海洋般困难。

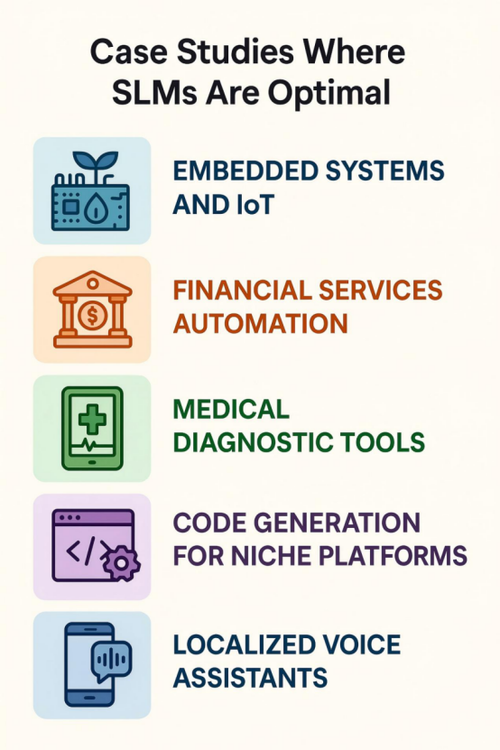

案例研究与实际示例

理论固然重要,但实际应用才能真正体现小型语言模型(SLM)的潜力。以下是SLM不仅可行且最优的五个场景,涵盖行业与问题类型,展示小模型如何在不冗余的情况下发挥作用。

嵌入式系统与物联网

用例: 偏远农业区域的智能灌溉系统。

假设某农业区部署了连接不稳定的智能灌溉系统,需分析传感器数据(如土壤湿度、湿度和天气预报),并为当地农民生成可操作的摘要与建议。

SLM直接嵌入传感器设备,解析来自湿度检测器、温度监测器和天气API的数据流。模型在本地生成自然语言摘要或“下一步行动”建议(例如“今日水位更优,无需灌溉”),而非将原始数据上传至云端。

SLM的优势:

部署于RAM <1GB的微控制器(如ARM Cortex-M处理器)

减少通信开销与延迟

支持无可靠互联网区域的决策

SLM可直接部署于边缘设备,解析数据并建议灌溉时间,无需依赖云服务器。这不仅关乎便利性,更涉及控制力、成本效益和自主性。

为何SLM更合适?

极低功耗需求

本地实时分析

无需持续互联网接入

该案例展示了AI如何在不加重算力负担的情况下扩展至基础设施级系统。

金融服务自动化

用例: 零售银行应用中的实时交易分类与警报。

在金融领域,一致性与延迟至关重要。每日分类数千笔交易、检测异常或为监管更新自动生成模板邮件时,容不得模糊或错误。

SLM经微调可识别交易模式并分类(如“公用事业”“订阅”“业务支出”),同时标记偏离预期用户行为的异常,为支持人员生成模板化警报或后续建议。

SLM的优势:

以<100ms延迟处理数千并发查询

提供可靠、结构化输出,避免幻觉(无意义生成)

在具备强审计追踪的内部基础设施上经济高效运行

SLM在此表现出色,因其提供可预测的高速响应。经机构数据和术语微调后,其运行可靠且无需承担庞大LLM的开销(或不可预测性)。

为何SLM更合适?

毫秒级响应时间

幻觉或偏离风险更低

更易审计和维护

因其可经济高效地大规模运行,SLM非常适合需要精确性的内部工具。

医疗诊断工具

用例: 本地诊所的初步分诊助手。

设想某偏远诊所网络不稳定且无云端服务器,医护人员需快速分诊支持:总结病史、识别风险标志并优先处理危急病例。

经医学历史和症状描述精选数据微调的SLM可协助护士优先处理病例,根据预定义临床规则突出关键风险指标(如“持续发热”“呼吸急促”)并映射至可能的病症。

SLM的优势:

完全离线运行:患者数据不离开本地

保持医学术语一致性

因可解释行为更易通过认证和验证

在此部署大型模型不可行,而训练良好的SLM托管于本地基础设施,可在不暴露敏感数据的前提下提供支持。

为何SLM更合适?

支持隐私优先的本地化部署

适配领域专有医学词汇

提供一致、可解释的结果

在医疗等受监管行业,SLM不仅节省资源,更守护信任。

利基平台代码生成

用例: Arduino或ESP32微控制器固件的快速原型开发。

并非所有开发者都在构建下一代Web应用。部分人专注于物联网设备、Arduino板或底层微控制器编程,这些场景内存紧张且需求具体。

经嵌入式系统代码(如MicroPython、C++)训练的SLM可协助开发者生成传感器设置函数、电机控制循环或网络配置代码,并直接集成至IDE以提升效率。

SLM的优势:

相比LLM代码,助手推理更快

因专注硬件特定语法训练而精度更高

可定期基于平台更新重训练

针对此类环境训练的SLM能生成精简、语法正确的代码片段,且因问题空间明确,模型无需数十亿参数即可胜任。

为何SLM更合适?

高效微调适配狭窄领域

硬件受限环境中的快速原型开发

为嵌入式平台定制的可预测输出

对于重视速度、范围控制和开发者自主权的团队,这是明确的选择。

本地化语音助手

用例: 农村政务应用的多语言语音支持。

以印度农村为例,多语言语音助手帮助用户查询天气预报、获取政府计划或管理日程,均使用当地方言。

若使用LLM,需权衡数据隐私和高昂成本。而SLM可实现设备端全处理,快速、隐私且离线可用。

经当地方言和文化特定短语微调的SLM可内置于低成本安卓手机的语音应用中。用户可提问“下次小麦补贴何时发放?”并以母语获得准确、情景感知的离线响应。

SLM的优势:

不依赖云端或互联网

更好满足政府数据的隐私合规

通过小更新周期适配区域语言差异

为何SLM更合适?

为低连接区域提供离线功能

避免数据传输以尊重用户隐私

通过方言特定训练实现文化适配

此时,SLM不仅是技术选择,更成为数字包容的桥梁。

选择合适模型:决策框架

以下简化决策表助你选择模型:

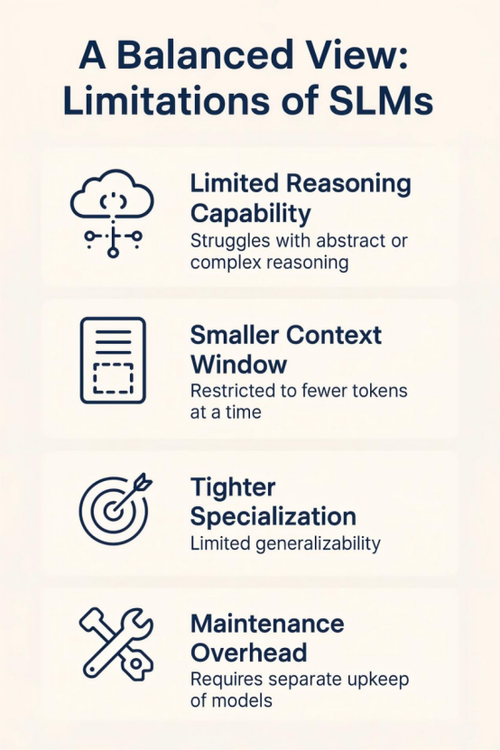

平衡视角:SLM的局限性

尽管SLM在许多用例中表现出色,但它们并非全能。理解其局限性对生产部署尤为重要,特别是如果你正在考虑生产部署。

有限推理能力: SLM处理抽象、多跳推理或长文本合成能力较弱。若任务涉及总结20页法律文件或处理模糊逻辑链,大型模型可能更优。

较小上下文窗口: 多数SLM仅能处理数千令牌(token),因而不适合长文档、长对话或需广泛背景知识的应用。

过度专业化: 专精是优势也是限制。专为医疗笔记微调的模型无法直接处理法律摘要或产品评论,需额外训练。

维护开销: 若需多个专用模型(如客服支持、内部搜索和HR摘要),需分别维护和监控各SLM,而集成良好的LLM可能通过智能提示统一处理。

SLM并非“全能模型”,其设计理念是“精准胜于强力,效率胜于广度”。当问题范围明确、约束真实且输出需可靠时,SLM是更优选择。

结论

小型语言模型(SLM)有助于优化成本与速度。它们从任务本身出发解决问题,引领我们进入更注重场景的AI生态。模型选择的核心是问题上下文,而非规模。

SLM的崛起不意味着LLM的终结。未来,我们将看到更多为特定目的构建的专用AI模型,而非仅为了炫技。

我们正朝着更精细、开源且专为狭窄任务优化的SLM迈进。SLM不再是LLM的缩小版,而是针对任务的解题专家。

原文链接:https://www.analyticsvidhya.com/blog/2025/04/slm-over-llm/