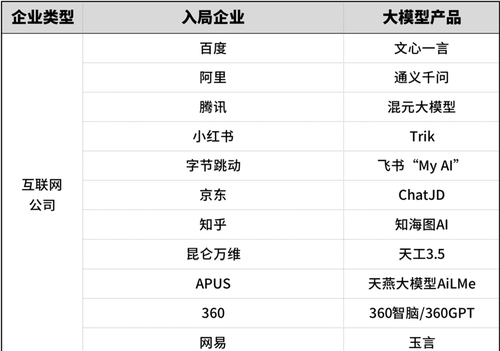

你知道现在国内有多少大模型吗

嘿嘿,说出来吓你一大跳

我手贱粗粗进行了不完全统计

说“百模大战”,绝对不过分

一时间,大模型就像AI救世主

拳打元宇宙,脚踢WEB3

还叫嚣着要把传统AI按在地上摩擦

这些一股脑“all in 大模型”的玩家

大多都有两个特点

1、家底殷实,能烧得起钱来炼模型

2、以“乙方”公司为主

急需一个拿捏住客户的AI破局利器

↓

可是,看看那些

真正想为AI买单的大甲方们

没听说谁在训练大模型

而乙方们造的这些大模型

除了在AIGC场景可以快速落地

碰到大甲方的垂直业务场景还是一头雾水

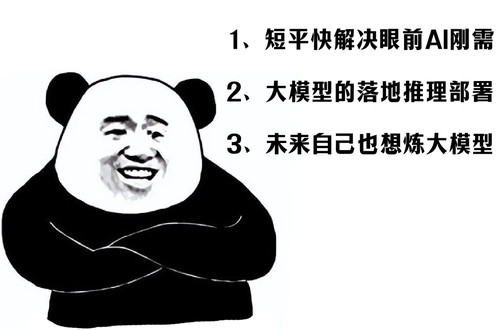

其实,大甲方们都精明得很

他们心里琢磨着三件事

↓

❶

不惜血本投入专用硬件炼大模型

更像是割韭菜、智商税

眼下手里那些火烧眉毛的急活儿

我希望能短平快、多快好省地搞定

(其实不光甲方肉疼,前面那些“不差钱儿”的乙方也苦加速卡久矣)

❷

当大模型真能落地的时候

我如何高性价比地适配并部署推理应用

❸

如果哪天,我自己真想要炼个大模型

有什么摸着石头过河的好方法?

所以呢,行情就是这么个行情

但大甲方们都务实的很

最看重的还是降本增效,解决实际问题

那这灵魂三问,该怎么解?

有没有踏踏实实能整活儿的?

▼

众里寻“他”千百度,蓦然回首

那人却在,灯火阑珊处

没错,这个踏踏实实整大活儿的

正是「英特尔」

↓

因为,从甲方看重ROI的立场出发

按行业分类的「中小模型」

更符合当下垂直行业的应用需求

因此,英特尔率先亮剑,发布了

「第四代英特尔®️至强®️可扩展处理器」

内置各种硬件加速器

被称为10年来数据中心级处理器最大提升

这些内置硬件加速器,个个大力出奇迹

为各种苛刻场景提供加速输出

(详情可以看这篇:这届CPU,说最狠的话,背最多的锅!)

其中,尤其针对「中小模型」应用场景

有一个特别“霸道”的加速器,这就是

↓

有多霸道?先说结果吧

有了AMX内置加速引擎

运行AI训练和推理任务的速度

比上一代产品能快3到10倍!

怎么做到的呢?

AMX是从指令集层面来实现加速的

可以显著加速深度学习算法中的矢量计算

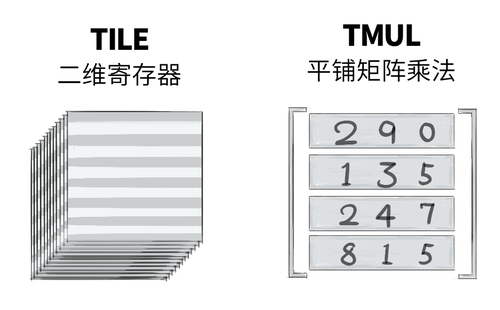

具体来看,AMX结构上包含两大部分

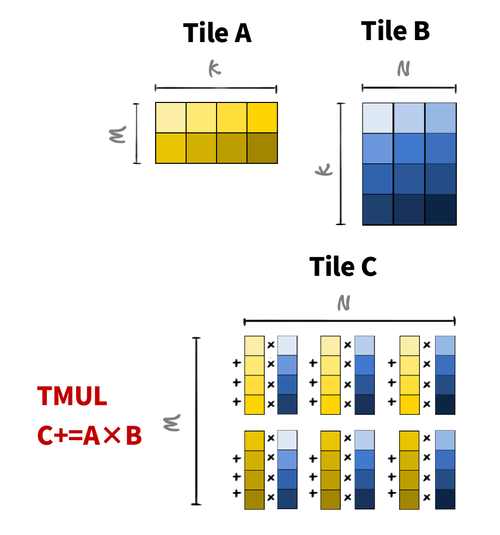

①一组叫做TILE的二维寄存器

②一组叫做TMUL的硬件逻辑

↓

相对于以前512比特的一维向量

如今的二维寄存器有了矩阵的概念

可以存储和操作更大的数据块

(8个寄存器,每个1KB)

而TMUL调用寄存器执行矩阵乘法运算

每个时钟周期完成2K次INT8或1K次BF16运算

说白了,在AI深度学习中

主要的算力开销就是矩阵乘法

AMX用TILES寄存器来存放矩阵

用TMUL硬件逻辑来完成矩阵乘法

这是一种「硬解」

↓

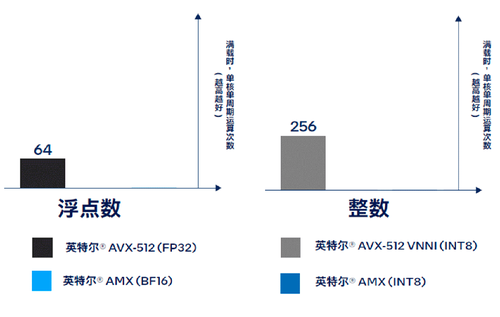

实际加速效果如何呢?

跟上一代没有AMX加持的处理器相比

运行浮点运算(BF16),可以提升16倍

而BF16是目前AI计算中最常用的数据类型

↓

注意哦,这是加速引擎额外提供的加成

并不耽误CPU干其他的通用计算任务

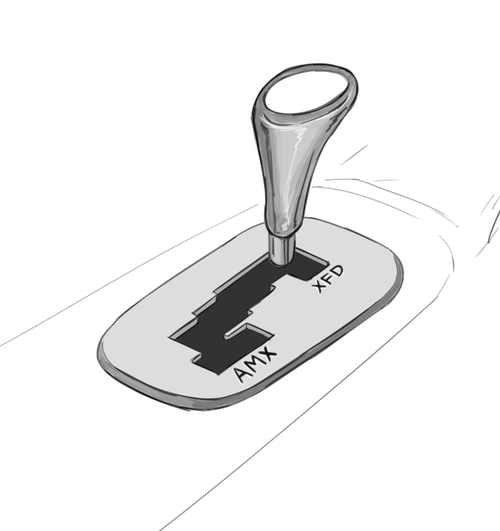

这就好比着用户买了一辆多功能跑车

平常可以都市代步通勤(通用算力)

一换挡秒变F1赛车驰骋赛场(AI算力)

这看起来不是炸裂的放卫星技术

但却非常实惠,堪称多快好省搞AI的利器

所以,一经发布,各方大佬纷纷出手

最关注性价比的他们,自然不会错过

↓

阿里云基于第四代至强®️,率先推出最新计算实例ECS g8i,有了AMX加速器的加持,深度学习性能大幅飙升。(训练性能提升2倍+,推理性能提升4倍)

腾讯则利用英特尔®️AMX优化BERT模型,显著提升了模型性能,并得以节省在部署昂贵的专用硬件、扩容服务器节点等方面的支出。

美团在多个视觉AI模型中,通过采用英特尔®️AMX加速技术,动态将模型数据类型从FP32转换为BF16,增加吞吐量并加速推理,性能实现3.38-4.13倍提升,精度损失大部分可以控制在0.01%-0.03%。得益于性能提升,美团能够降低视觉AI服务的投资规模,并节省70%的服务成本

总之

互联网大佬们都在用英特尔®️AMX

而且已经深刻体会到了加速的快感

那么,我们再看看大甲方的灵魂三问

英特尔能搞定吗?

↓

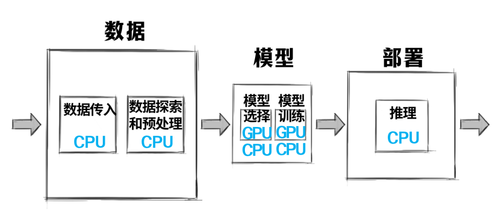

第一,对于那些经典AI的问题

其实很简单

大甲方手里有数据,有具体业务场景

那就按照标准AI流水线的套路

轻车熟路地来跑就可以

在这个过程中,CPU是主力扛活的

大甲方不用下血本买什么加速卡

不必整什么大集群大阵仗

使用他们熟悉又亲切的CPU解决方案

只需给通用算力集群来个“换挡”操作

把英特尔®️AMX的潜能激活

嘿嘿,走起,享受一下“松弛感”

来看具体落地,下面这组数据非常明显

对付各种主流场景无论训练还是推理

有了AMX,性能飙到飞起

关键是,不依赖额外的加速卡

通用计算+AI计算通吃

↓

第二,如何把大模型快速适配到生产环境

大模型落地到B端业务场景

主要是适配和推理部署的问题

这里,我们要普及一个事实

全球70%的数据中心AI推理任务

是在英特尔®️至强®️可扩展处理器上运行的

如今,有了AMX加速助力

更是如虎添翼

用户可以一边运行通用工作负载

一边轻松完成大模型的部署推理

第三,未来甲方自己想炼大模型怎么整

针对这个需求

英特尔给出了大模型/生成式AI「全家桶」

【SPR+Habana/Xe+oneAPI】

❶ 集成AMX加速引擎的CPU:也就是第四代英特尔®️至强®️可扩展处理器及后续产品;

❷ Habana加速卡与XE GPU:包括Gaudi2、GPU Max系列、Flex系列GPU等等,性能爆棚;

❸oneAPI:面向各类计算架构的统一编程模型和应用程序接口,串联所有,一统江湖,极大降低AI开发者工作量。

至此,三个让甲方焦虑的问题

英特尔都给出了解决方案

不得不说,姜还是老的辣

无论看得清的AI需求

还是看不清的AI需求

你可以永远相信英特尔!

针对通用计算、AI推理、AI训练,小/中/大模型,英特尔全部都有高性价比解决方案,另外别忘了,英特尔还有强大且免费的AI软件和技术支撑服务。